2026 年 ChatGPT 要加广告了,最懂你的 AI 都开始出卖你

2026 年,很可能是人类首次需要给 AI 安装「广告拦截器」的一年。

就在今天凌晨,据 The Information 爆料称,OpenAI 员工正在琢磨如何让 ChatGPT 在用户提出相关问题时,优先显示「赞助内容」。比如你问睫毛膏推荐,就可能看到厂商的软广。

近几周内,OpenAI 的员工还制作了多种广告展示方式的原型图,其中就包括可能会出现在 ChatGPT 的界面侧边栏中。

从 2023 到 2024 年,硅谷的主流想象是优雅的。不少人笃定,大模型可以走 SaaS 模式,用户会像订 Netflix、Spotify 一样,每个月付 20 美元,然后就能清清爽爽地用上 AI 的服务。

但到了今年,这个幻想基本破产了。

因为 AGI 还没来,账单先到了。可以预见的是,明年更多 AI 产品会开始试探性地「上广告」。有的会明说,有的会伪装成推荐和合作,有的干脆就埋在交互里。

这多少带点黑色幽默:当我们还在仰望 AGI 统治世界的宏大愿景,没承想,它先学会的生存技能,竟然是靠广告「恰饭」。

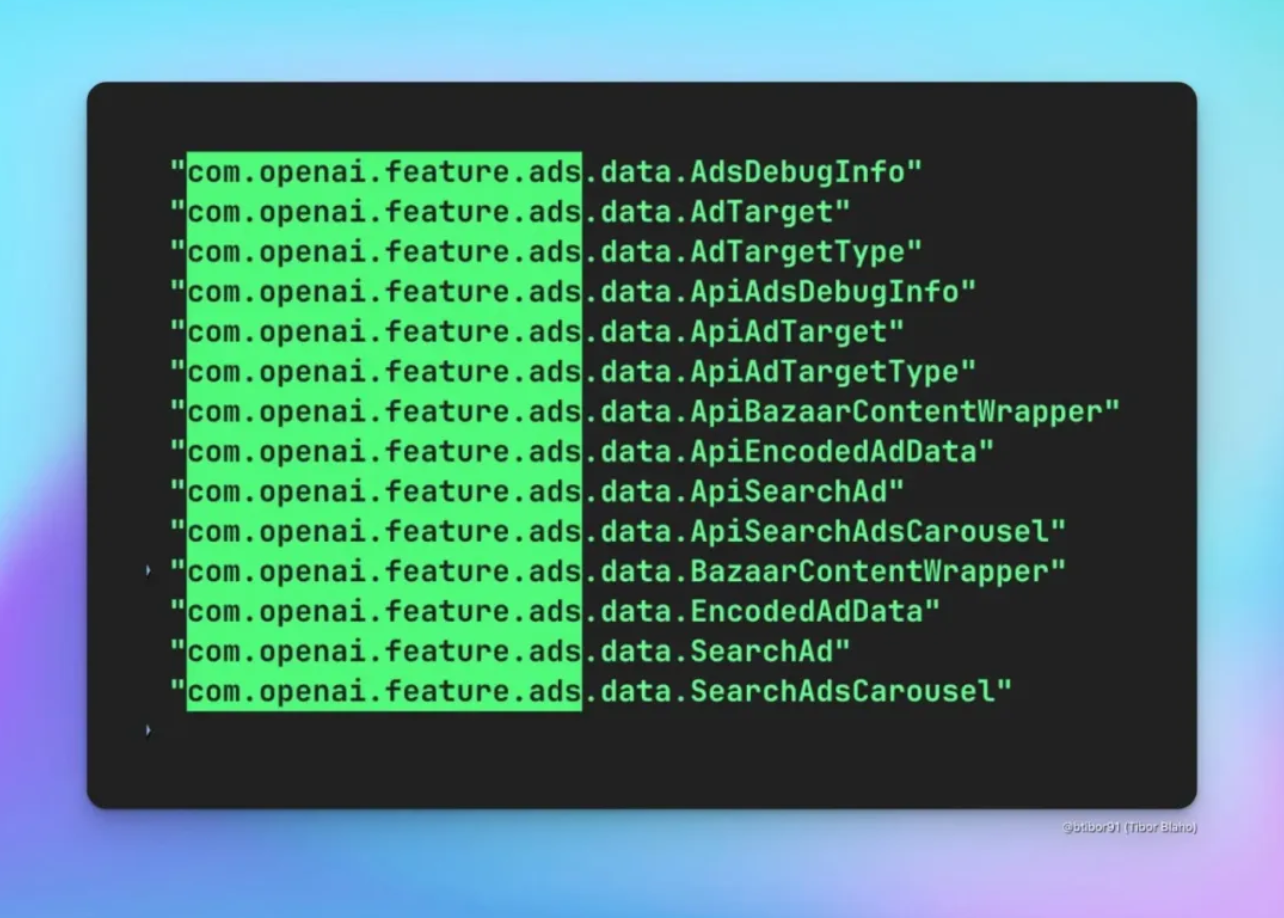

▲ChatGPT 投放广告的泄露代码 | 图源自 Tibor

往 AI 加广告是回血捷径,也是想象力破产

先承认一个现实。在持续烧钱的大模型时代,「在 AI 里加广告」确实是最稳、最快的回血方式。

互联网已经替它们踩过一遍坑了。最早的门户网站卖广告位,后来搜索引擎卖关键词,社交网络和短视频平台卖信息流。

套路其实没变多少。先把人聚集过来,再把这些注意力打包卖给广告主。广告的形态越来越隐蔽,系统却越来越成熟。

AI 现在面临的处境,和当年互联网很像。

用户数狂飙,收入跟不上,订阅还在慢慢教育市场,企业付费项目周期长。理想和现实之间,隔着一个越来越大的亏损窟窿。

于是,贩卖广告成了一根放在 AI 牌桌上的救命稻草。谁压力大,谁就得先伸手。只是,谁先在对话里明目张胆地塞广告,谁就有可能先把最敏感、最挑剔的那批用户送到别家模型那里去。

囚徒困境的道理不外如此。

只要还有一家坚持不加广告,其它玩家在加广告时就会有顾虑,怕自己变成那个先被抛弃的人。而一旦多家同时迈出那一步,这种顾虑就被集体摊平了,谁也不用再装清白了。

把这个视角放到 Gemini 身上,就更清晰了。最近多家媒体援引广告代理商买家消息称,Google Gemini 的运营方已经告诉部分广告客户:计划于 2026 年在 Gemini AI 中植入广告。

从广告主视角看,这对他们来说是极具吸引力的新渠道:大模型的尽头不是 AGI,是 CPM(千次展示成本),而聊天环境 + 巨量用户则 = 极有潜力的变现空间。

但很快,Google 全球广告部负责人 Dan Taylor 在社交媒体上直接否认了这一说法,称「Gemini App 目前没有广告,也没有当前计划改变这一点」。这说明,Google 至少在公开语境里是保持谨慎的。

把镜头拉到 OpenAI CEO Sam Altman 身上,则能看到一个很典型的摇摆轨迹。

ChatGPT 刚火的那一两年,他反复强调自己不喜欢广告,尤其是「广告 + AI」这种组合,在公开场合叫它「让人格外不安」。

他更偏爱的是干净的订阅模式:用户直接付费,用钱换取不被广告商左右的答案。最多可以接受一种「导购分成」的想象——用户自己做完调研、自己下单,平台从成交里抽一小口,而不是收钱去调换答案的先后顺序。

到了 2025 年,他的话锋明显软了下来。

他开始承认「自己其实挺喜欢 Instagram 上那些精准广告」,觉得能帮自己发现好东西还挺酷,顺势改口:广告未必一无是处,关键看形态是不是足够有用、足够不讨人厌。

根据 The Information 的报道,OpenAI 正在寻求创造一种「新型数字广告」,而不是简单照搬现有的社交媒体广告形式。

ChatGPT 可以通过详细对话收集大量用户兴趣相关信息,OpenAI 曾考虑是否可以基于这些聊天记录来展示广告。方案之一就是在用户使用 ChatGPT 提问时,对「赞助信息」给予优先展示,比如可被设定为在生成回答时优先插入广告内容。

据知情人士透露,最近一些广告原型图中,广告被设计为出现在 ChatGPT 主回答窗口的侧边栏。此外,员工还讨论了是否应添加类似「本回答包含赞助内容」的声明。

一位知情人士表示,OpenAI 的目标是让广告尽量「不打扰用户」,同时维护用户信任。例如,广告只在对话进行到特定阶段后才出现:当用户询问巴塞罗那行程时,ChatGPT 会推荐圣家堂(非赞助),但点击链接后可能弹出付费导览服务的赞助商家。

与此同时,为了 OpenAI 的商业化发展,奥特曼更是操碎了心,一大早请来负责应用和商业化的高管,公开物色「广告负责人」,探索把 ChatGPT 变成广告平台的路径。比如 CFO Sarah Friar 就是实打实从广告系统磨炼出来的沙场老将。

包括即便奥特曼拉响了红色警报,但营收依旧是头等大事,并因此加码挖来前 Slack CEO Denise Dresser 做首席营收官,把「怎么赚钱」这件事提到了公司最高优先级。

嘴上是理想主义,实际心里全是生意。

当然,单看商业逻辑,这样做其实也没啥问题。数据不会说谎,OpenAI 的年化收入大概 120 多亿美元,听上去很亮眼,但烧钱速度却可能是公开数据的三倍。

预训练要烧钱,上线之后每一次推理也要烧钱。推理成本确实在降,但可杰文斯悖论印证了一点,当算力便宜一点,用户也只会立刻拿它去跑更复杂的模型,这也就造成企业需要购买越来越多的 GPU,电费账单也像滚雪球一样。

简言之,单位成本是降了,但总账一点没省。

根据 OpenAI 截至今年 7 月的统计,ChatGPT 约有 3500 万的付费用户,占周活跃用户的 5%,与此同时,订阅营收也占据了以 OpenAI 为代表的绝大多数 AI 企业的大头。

在这种背景下,所有 AI 公司都要面对一个简单粗暴的问题:钱从哪儿来。

最直接的答案,就是在 AI 里塞广告。

广告之所以成为原罪,是因为当年互联网缺乏其他有效的商业选择。同样在 AI 时代,如果没有创新模式,广告依然是覆盖大部分用户成本的唯一手段。

当然,如果照抄上一个时代赚钱方式的做法,显然是一种缺乏想象力的路径依赖。传统互联网已经证明过一次,当你手里只有锤子,所有问题都像钉子,当你只会做广告,所有产品都像广告位。

ChatGPT 广告同样面临挑战:截至今年 6 月,仅 2.1% 的查询涉及购物。为此,OpenAI 已接入 Stripe 支付、Shopify 电商、Zillow 房产和 DoorDash 送餐等功能,既培养用户购物习惯,也为广告投放积累数据。

收入模式决定产品形态,用户体验通常就会变成那个被牺牲的变量。AI 本被寄予厚望,被视为跳出旧时代泥潭的机会,谁也不希望兜兜转转,我们还是在同一个泥坑里打滚。

最懂你的 AI,开始给你带货

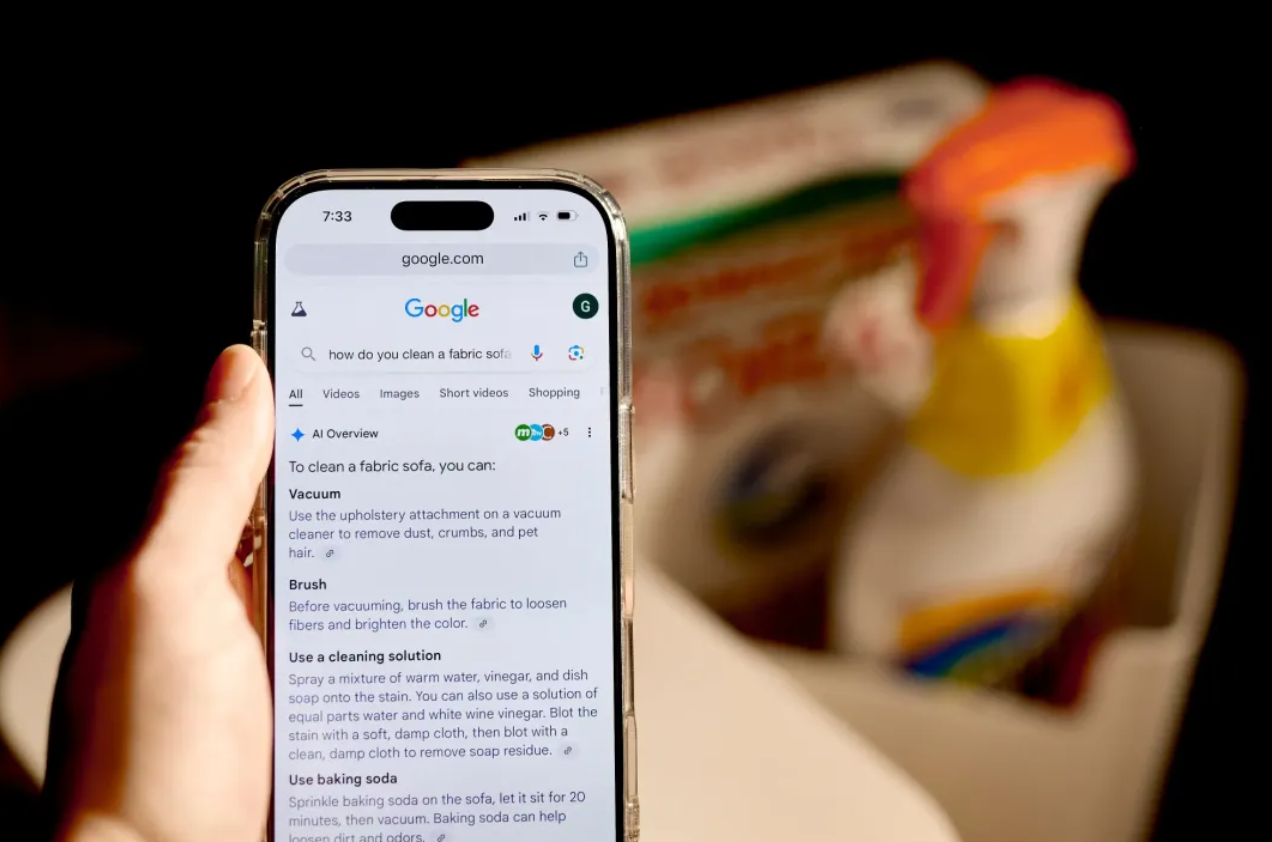

传统互联网加广告的方式,究其本质,不外乎用一块块醒目的位置贩卖注意力,更典型的是早年的搜索引擎广告。

页面看上去是搜索结果,实际前几条全是竞价排名。那时候的事故和争议,现在回头看都让人后脊发凉。

在 AI 里插广告,会比这些更危险。

经验丰富的我们对网页广告是有天然戒心的,对搜索结果也大概知道要多对比几条,知道上面这几个很可能是广告。但面对拟人共情的 AI 陷阱在于,我们可能会忘记屏幕对面可能站着一个销售团队。你把 AI 当老师,它把你当待转化的潜在客户。

回顾历史,苏东坡给卖馓子的小摊写了「纤手搓来玉色匀,碧油煎出嫩黄深。夜来春睡知轻重,压扁佳人缠臂金。」,从此客似云来。人们买的不是馓子本身,而是名人苏东坡的信任。

今天的 AI,在许多场景里就是那个被普通用户默认可信任的苏东坡。

尤其危险的一点,是现在不仅是简单的广告植入,还有人在用 GEO 做「内容投毒」。

GEO,顾名思义,是「生成式引擎优化」(Generative Engine Optimization),目的是让某篇网页或文章在 ChatGPT、Gemini、Perplexity 等 AI 回答引擎中被优先引用。

想象这样一个场景:某些厂商或利益方,提前发布大量优化过的网页文章,专门针对某种产品或服务写得很权威、很完整,并加了结构化标签、SEO 元数据、关键字提示等。

他们的目的不是为了帮助,而是为了确保当用户在 AI 里询问相关问题时,他们的内容被优先输出。接着,AI 把这些内容编入答案。

对用户来说,这就是「权威建议 + 中立信息」。而实际上,它可能是一个包装得像专家建议的商业推广/投毒结果。

这比传统的广告或者软文更可怕,因为它隐藏在「答案」的核心里,不是在醒目的广告位,而是在用户最信任的建议或者结论中。每隔几段文字,我们都需要确认,AI 的这个建议,到底是在为我着想,还是在帮谁带货。

光是把广告藏进一句话里,危险已经不小了。更重要的是,AI 还在谋划下一步,把自己挪到所有 App 的上游,干脆接管「谁来给你打广告」这件事。

传统互联网时代,每个超级 App 都想当入口。各自圈地、自建城墙。用户直接打开它们,再由它们负责往你眼前塞内容、塞服务、塞广告。

超级 App 做了十年的围墙花园,但 AI Agent 想一夜推平。

理论上,它具备跨应用操作能力,可以帮你完成「打开某 App 搜一下、多平台比价、自动填表下单」这种操作。你不再需要自己点来点去了,甚至不需要记住每一个 App 的入口。

这就点出了最近豆包手机助手一上线就被各家 App 集体「拉黑」的根本原因。

本质上,这是一场零和博弈的入口之争。

谁离用户更近,谁就能决定用户看到什么。当豆包通过和手机厂商合作,拿到了系统级权限,可以帮用户跨 App 点外卖、订机票、比价购物,甚至回消息,也就意味着所有 App 成了豆包手机助手的「后端服务」。

于是不出意外,各大 APP 纷纷以「安全」为理由,限制豆包手机助手的自动化操作,甚至直接强制下线。

这是一次不折不扣的预演。

未来真正的 AI Agent,如果成为大多数人默认的上网入口,那些原本靠广告赚钱的应用,要么被迫给 AI 交「保护费」,要么退回后台,当一个没有品牌存在感的接口。

新闻网站已经先走了一遍。据媒体公司 Raptive 预计,Google 新上线的 AI 概览功能最终将导致许多出版商网站流量流失 25%。虽然目前受影响程度还不算最严重,但随着 AI 概览应用范围扩大,影响将进一步加剧。

有了聚合平台之后,它们慢慢从直接面向读者的平台,变成了内容供应商,现在轮到消费者应用迎来同样命运。甚至于所有应用都要排队伺候 AI 管家时,最需要有人盯紧的,其实是这个管家本身。

一方面,过去广告的目标是说服一个个具体的人:想尽办法抢占人的注意力,在人的时间线里插播内容。而在 AI Agent 主导的世界里,广告主首先要说服的,变成了帮人做决策的 Agent。

另一方面,这也意味着未来大部分广告团队都需要认真思考:当用户不再自己逛应用,而是让 Agent 替自己逛时,我的广告要投给谁?要怎么投?

是的,如果 AI Agent 同时又是广告平台,它就会同时拥有两种权力。

决定你去哪儿,决定你看到什么。它可以替你选酒店、选机票、选保险、选医生,还可以在每一个选择的背后挂上自己的返佣和广告逻辑。

尤其是,AI 助手可以深入理解用户当前的需求和意图,从而插入高度相关的广告推荐,这比传统网页根据关键词投放广告更进一步,可能达到类似真人顾问的推荐效果。

以及 AI 助手与用户的交互积累了大量个人隐私数据——包括用户的偏好、习惯、地理位置、社交关系等。如果这些被用于广告定向,广告的针对性将前所未有地强。

回到开头那个预言。

2026 年的杀手级应用可能不是某个聊天机器人,而是「Adblock for intelligence」。每一代新技术都声称自己不一样,最后都在广告里找到了归宿。

过去老牌浏览器插件 Adblock 拦的是网页广告,现在的「Adblock for intelligence」要拦的,是那些未来渗透在 AI 回答里、伪装成中立建议的软性广告和不客观的信息。

在 AI 试图接管我们大脑的时代,保持怀疑,并拥有「拒绝被喂养」的能力,将是人类最后的尊严。

作者:莫崇宇

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。

https://www.theinformation.com/articles/openais-organizational-problems-hurt-chatgpt?rc=qmzset

https://www.theinformation.com/articles/openais-organizational-problems-hurt-chatgpt?rc=qmzset