对话 vivo OS 产品副总裁:AI 不会产生新的需求,通往远方是马车还是蒸汽机是产品形式问题

如果说智能手机操作系统的上半场,是把功能装进一个个按钮、一个个 app,那么在今年 vivo 开发者大会亮相的 OriginOS 6 则再一次印证,AI 和 OS 不可逆转的融合趋势。

除了 PPT 上多模态、推理能力、长文本处理这些热词,AI 已经不甘于成为手机系统的「功能清单」。

vivo 提出要做 UI Agent,试图让 AI 真正理解用户意图,用一次自然的请求,完成跨 App 的整场协作。

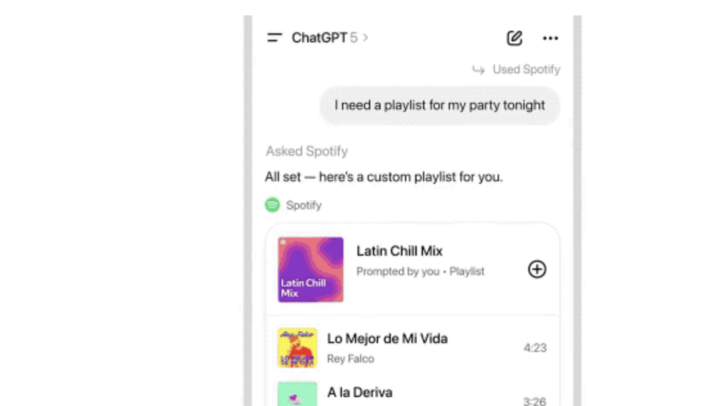

巧合的是,几天前的 OpenAI DevDay 也在谈同一件事:宣布把 ChatGPT 变成一种「操作系统」。一句话,Spotify、Canva 在对话里自动唤起;一个面板,交互就地完成。对话即应用,应用即接口。

当 OS 学会理解人,当模型学会调度应用,AI 与 OS 的边界开始变得多余,是殊途同归,还是将分岔出全新的生态?

在开发者大会演讲后,爱范儿与媒体专访了 vivo OS 产品副总裁、AI 全球研究院院长 周围,以及 vivo AI 产品总经理 关岩冰 和 AI OS 产品总监黄梓勋。

AI 与操作系统:趋势与分歧

Q:今年各家厂商都在谈「AI 手机」,但概念众多——AI 原生、智能体、AI 操作系统。你怎么看当前行业在 AI 手机方向上的探索阶段?

周围: 其实 AI 和手机一直是三个问题要解决的。

第一,一定要有大模型的能力,而且我们比行业大模型还要多一个,就是一定能够端侧化,如果不能端侧化就跟行业里用云服务没有什么区别。而且你用云能力或者是端侧化能力一定要个人化,如果不能个人化就跟通用能力没什么区别。恰恰个性化和个人化还是有价值的,因为我们每个人希望这个手机在身边能不能做做助理,管管日程。所以你会发现一定要建模型相关的能力,这是第一层,vivo 在这方面做得很扎实。

第二,AI 和手机的结合,我以「理工男」的角度是做两件事情:1. 手机系统能力的 AI 化,去年我们也做了 Writing to Ask、Image 这些公共的能力(系统的能力),你一定要有这样的能力才能给上面做应用。2. 除了这个能力外,我们厂商能做很多部分,手机用户能够感受到的也有 100 多个模块,这些能力肯定要自己先做,我们把它做一个「通控设施组」(通知中心、控制中心)我们自己有一个口诀。但是用户用手机,手机厂商只占了 15% 的时长,还有 85% 的时长是由开发者给我们的服务和能力提供的,特别是头部的互联网厂商又在这 85% 中占了 80% 或者是 70%,他们的参与度还是非常重的。

所以,第三个问题是对于上层的服务中还有 85%,这些事情应该怎么做?我们在这里面要分两件事情来做:第一是愿意跟我们握手,一起的就坐下来商量来做。第二是 AI 时代到来了,是不是需要有一个全新的江湖地位和影响力,这个就留给时间晚一点来回答也可以。

我们觉得 AI 和手机的融合,我大概把它分成这三层:下面的是大模型和能力,中间的系统基础能力建设,基础能力建设。真正到上层的应用,我们做厂商的和三方的就分成两块来做,像阿里愿意做的就坐下来做,还有一些不愿意做的就留给时间。这些是 AI 和手机融合以及 Agent 相关的问题是这样来对待和处理的。

Q:前几天 OpenAI 宣布要做操作系统,一个很大的变化叫作「对话即应用」,我们可以直接在 ChatGPT 上调用 figma、spotify 这种应用的功能。我们知道手机是是互联网时代很重要的入口,现在大家就觉得未来会不会直接在巨大的 AI 对话中就成了一个关键入口,作为手机厂商 vivo 怎么看这个趋势?

黄梓勋: 我们作为手机厂商确实跟 ChatGPT 这样的公司有不同的角度,一方面我们有蓝心小 V 这样的 AI 助手,它确实是对话式的调用应用和能力,这方面要持续建设的。

另一方面是用户使用手机的时候,比如说该打电话的时候会打开电话应用,打车的时候会打开打车应用,这方面不会刻意的一定要用对话去解决,比如说整个系统的意图框架能够更快满足用户对于应用的调用,甚至是对于三方 Agent 的调用,这是我们认为最合适的方式。

比如说大家现在看到通过原子岛推荐出来的可能是一个服务的接口、服务的入口,但是也可能逐渐推荐出来是三方的 Agent,你要用对话去推进 Agent 吗?也不一定,因为现在对 OS 的使用上,用户比较依赖 GUI 的界面手势交互会比较多。所以在 OS 的角度上还是考虑用户在不同场景下怎么样更快、更便捷的获得服务,无论这个服务是接口式的服务直达还是 Agent 的服务推送。

确实我们在蓝心小 v 方面也会加强以对话式的方式,甚至是结合界面的主动交互的方式能够更快让用户获得。

关岩冰: 我认为国内外生态有一定的差异,ChatGPT 支持 COS、Spotify,包括还有 figma 这些作图软件,在海外有生态的基础,在国内确确实实有一点不一样。

第二,我认为它不是非此即彼的绝对的 0 或者是 1 的问题。举个例子,类似于蓝心小 v 这样的 AI 助手,早上发布会也讲,它善于解决的是用户个性化的需求,在传统的 APP 或者是互联网生态,比如说传统 APP 一个界面就是手机尺寸的大小,一个界面能放 10 个按钮或者是 15 个按钮,但总有大量的用户的需求不是这 10 个按钮或者是 15 个按钮,他找不到这些需求,其实这些需求是很长尾的很个性化的,这些需求适合用 AI 助手来解决。

今天上午有一个 demo 的例子是「你把这张图片转化成皮克斯风格,并且设置为壁纸」,这种长尾性的需求在传统的 APP 是不会做的,但是非常适合 AI 助手,因为非常个人化和非常个性化。

未来我们觉得这个生态可能有一个阶段,它不是说要不就是 APP 生态,要不就是流量入口,这不绝对。还是要回到用户需求,有一部分用户需求在这个阶段更适合用 AI 助手和 Chatbot 的方式来解决,对用户需求会更好。

周围: 其实用大模型做应用现在百花齐放,我们更关注的还是既要做能力的建设,同时也要很克制在面对这样的情况。我们不能避免的是在做用户习惯和服务的分发,接下来的策略可能是第一建好能力,第二是需要合作伙伴跟我们一起来做这件事情,对于有疑虑的服务的提供商可能还是希望大家观望一下,克制一下。

端侧模型与能力建设

Q:现在每个厂商都要做端侧大模型,也基本上每个厂商都说要做个人助理。vivo 提出的「UI Agent」概念,与其他厂商的 AI 助手有什么不同?

关岩冰: 今天上午讲到我们的选择是个人化智能,并不是所有的厂商都是个人化智能。我们觉得个人化智能就有几个特性:

第一,它像你身边的朋友或者是一个伙伴,所以我们有一个很核心的能力就是端侧,因为只有端侧才能无时无刻在分析你的数据、洞察你的需求、感知手机上的屏幕等等。其实并不是所有的手机厂商都具备端侧的能力,就像刚才周围总讲的我们在端侧的能力上还是比较出色的。

第二,真正多模态的自然交互,它包括语音上的交互,包括 UI Agent 所带来的我们对屏幕、图像感知上的交互,这也是一种交互,包括我们在文本上的交互。因为有多模态的交互所以才能保持交互会更自然,就像一个人一样跟你交互。这是我们两个核心的差异化的点或者是优势,相对于其他的厂商而言。这两个优势才能保证我们做的东西无时无刻在手机上,而且无时无刻给你提供符合你个人的个性化的服务。

Q:理想的 AI 智能体需要哪些条件?哪些已经具备?

周围: 以前手机是 APP 应用分发的渠道,其实整个行业对于软件商店的分发的权限在哪里,边界在哪里我们是很敏感的。其实智能体时代的分发也是同样敏感的问题,vivo 的企业文化是希望共赢共建的,所以对未来 AI 智能体的分发我们作为一个手机渠道,我们还是希望克制和共建。

哪些能做哪些不能做呢?第一,我们希望智能体对于手机本机的功能和系统能够做到的我们都做了。第二,同样这些智能体的 Agent 商店、包括个人化智能要搭载的框架,这是平台厂商要做的,所以这些工作都就绪了。

但是在跨 Agent,Agent 之间通信的时候是整个行业共建的事情,还有一个重要的参与者是「开发者」,主要是互联网的厂商。面对这个问题时,我们希望是一起商量着来建的,所以还有哪些做不到的就希望在互联网应用 Agent 的分发上,我们是希望「商量」着来、是共建的。不是说我们做不到,而是这件事情是行业共建利益的事情,vivo 还是有自己的本分需要坚守的。

Q:现在智能手机所谓 AI Agent 的能力,其实离广泛意义上定义的能力有点远,因为可能每个 app 的信息孤岛不会把底层数据给到手机厂商,有些厂商会通过无障碍功能识屏的方式曲线救国。这是主要障碍吗?

周围: 今天你的感受跟我们的感受是一样的,当智能体特别是手机的自动智能体要做任务的时候,我们只能做厂商自己的功能、自己的应用,比如说秀一下是否流畅、调一下亮度、连接一下 Wi-Fi 都没有问题,但是你想跨应用,对方目前是抓住安全授权的标准在和终端厂商有一个讨论的过程。

我们觉得作为一个终端厂商,第一是要积极推动行业标准的建立,第二是 AI 技术从现在到成熟还有几年的过程。今年我们也在大方宣布基于手机界面 UI 的自动识别和操作,这些能力会每年越来越成熟。而对于互联网行业他们哪天需要厂商一起服务用户的时候,我们自然就一拍即合。

我相信互联网行业里有很多这样的公司他们是很大方在做这样的事情,他们都在和我们做这样的事情。也有很多担心未来的界限在哪里搞不清楚的,有很多这样的公司,我们就觉得留给时间来回答。

Q:vivo 与国内大厂在 Agent 上的合作现状?

关岩冰: vivo 现在是以比较开放的心态跟很多大的厂商合作,包括高德、百度,包括蚂蚁的支付宝,我们今天已经有很多合作了,未来 OS6 在很多 Agent 在未来一个月内会逐步上线,我们以开放的心态来接受,我们认为不是非黑即白,不是说 Agent 做了之后传统业务就没法做了。

Q:去年 vivo 还在谈 175B 超大模型,如今重点转向 3B 的端侧 AI,为什么?

周围: 可以这么说,去年我们做了 13B 和 7B 的端侧模型的实现,最后发现其实只有 7B 堪堪能上线,但是 7B 的模型在手机上跑得不是太理想,它占的内存比较大。直到今年发现 3B 上得比较好。

为什么有这样的选择?因为我们没有打开这个盒子,我们要知道端侧模型在手机上要做哪些事情,先要把手机上做的事情识别出来。

第一,它一直在识别人在手机上做的各种操作,举个例子只有 vivo 手机能够做到的,如果你查一个图标,或者是滑动选择一行文字,或者在页面上做一个全选,你发现 vivo 的原子岛有一个东西下来接你,这就是意图识别,这是在端侧上能够做到的。而且只有我们在端侧上能够做到,因为我们有一个端侧模型实时分析你要做的事情,比如说这个地址存在便笺里是要做导航,还是做日程的添加呢?我们有端侧模型在实时识别你的意图。这意味着手机里有非常多的识别意图、拆解任务等一系列的工作在做。我们这个功能 2024 年对行业发布,我们希望有些事情是需要蹚过之后才有心得,才能做正确的选择。

今年我们旗帜鲜明做选择的时候,并不意味着 3B 是唯一做的,其实很多 1B 的模型其实也是一直在做的。刚才您的问题是不是 1750 的模型就不做了,1000 亿的模型就不做了,70B 的模型就不做了?NO,是因为当下今年的大模型比去年的大模型功能更强,去年的大模型比前年的大模型的功能也更强。我们发现云端的功能相对容易做,真正难的恰恰是端侧的能力比较难。

今年 70B(700 亿)参数的大模型比去年 175B(1750 亿)的参数还要强了,我们 3B 的模型比过去 10B 的模型还要强,已经比 2023 年 1000 多亿参数的模型还要强,已经能够满足今天端侧任务和复杂任务的拆解,不是因为我们放弃云端,而是分成了两个阶段,云端是云端,端侧是端侧,云端的能力已相对比较容易建立。

现在大模型有两个话题,一是满足日常推理和复杂任务的拆解;二是通用人工智能,现在媒体上吵的是通用人工智能时代还没有到来,其实复杂任务的拆解、知识的获取和提炼已经能够满足我们使用的。

作为手机厂商对于 AI 的探索和需求需要更前置一点点,就是需要在 1B、3B 对用户的意图和日常任务的拆解,中台、感知、执行都是用端侧模型在做。只是感觉今天外面的媒体在探讨大模型的时候很少触及这种归类,毕竟我们是制造终端厂商,很难在媒体上发起这样的探讨。

Q:3B 模型有哪些关键突破?

周围: 原来 7B 的时候最大的问题是需要 3.5G 的内存,8G 的手机是中高端机型的主要配置,包括旗舰机都有 8G 配置的,一个大模型端侧就占了 4 个 G,剩下也只有 4 个 G 的内存,4G 的配置是目前低端机的标准配置,它这样一下就把高端机变成了低端机。这是第一个要解决的问题。

第二个要解决的是 7B 模型只能做简单的任务拆解,不能做复杂的推理。比如说「帮我看一下今天下午 4 点北京到深圳的机票哪一个最便宜?」就这一句话你可能要下载 3-4 个卖机票的服务,还要去比价。

你会发现里面还有分析哪一个应用,查哪个 APP 的价格,还要看我坐哪个航司的习惯,这是一个复杂的问题。去年的 7B 就做不到。而今年的 3B 远超去年的 7B,而且所有的榜单里还有做 8B 的,8B 比 7B 强,我们几乎把全球能找到 8B 的推理模型做了评测,我们的 3B 要远超他的,从推理能力、归纳综合能力、复杂任务拆解能力都比它要强。

我们解决了两个问题:第一,3B 端侧模型内存只占 2G,其实不影响高端机的性能,我们解决这个第一号难题。第二,大幅度增强了推理能力,几乎可以把它放在手机做意图中控和任务拆解的中台,这两个问题都解决了

其实还有别的问题,比如说这次也非常在乎功能,今年做到 200 tokens,去年是做 80 几,今年直接做到 200 tokens,200 tokens 已经很厉害了,平时我们看一个屏幕吐词,基本上 26 左右你就觉得还行,我们直接干到 200 tokens,说明端侧的出词效能直接起飞的,这方面没有障碍了。

还有一个功能可能大家没有关注到的,其实是我们真正颠覆性的。在 DeepSeek 之前有一个月之暗面大模型,他最大的特点是长 tokens,我们这次也做到了。这个是巨大的突破,而且我们这一点也是做得极其优秀的,只是因为刚做出来,从做出来让用户感知到明显的利益可能还需要大半年来沉淀。所以您刚才的问题也问出了我们这一年做的一些东西,长 tokens 我们在端侧上做到了。内存直接把原来的 4G 做到现在的 2GB,出词速度做到 200 tokens,包括本身的推理能力也做得好,而且把它全部做到了手机上。所以 2025 年的原系统 6 给我们 3-6 个月的时间在功能体验上也许还有预期之外的意外的惊喜。

Q:DeepSeek 的开源对你们有影响吗?

周围: 对我们有影响。我们是 2024 年意识到这个问题的,当时我们做 1750 亿的模型,做出来之后往下卷,其实卷的是矩阵模式。但是我们马上就发现万卡集群都不够用了,我们要做两万卡以上的集群,两万卡和一万卡光设备就要加 20 几亿,而且这还远远不够。这样下去卷通用人工智能我觉得不太现实。

中国做大模型的行业,大家也知道很多创业公司也卷不动。因为募资几百亿,做个 4000 亿的参数,可能要花 50 亿买算力,而且这 50 亿里还要三分之一,差不多是 15 亿是电费,往后每年烧电还要烧这么多钱,所以就烧不起。

当 DeepSeek 出来之后,对于千亿大模型一下就把大家拉齐了,因为 DeepSeek 做了很了不起的事情是完全开源的,而且可以让我们满血部署。vivo 的蓝心小 v 中有深度思考的模式,其实它是一个满血版的 DeepSeek。这就让我们觉得可以一下拿到很好的大模型。

对于我们这种自己做模型的公司有什么好处呢?就是辅助我们的 7B 和 3B 蒸馏学习。我觉得 DeepSeek 对于我们这种又要做模型训练训练又要做优化的公司来说是极其巨大的帮助和提升。

Q:为什么还要做 1B?它在端侧体系中的角色是什么?

周围: 感谢 DeepSeek 这两年给行业的推理能力带来极大的提升,去年我们还做了一个 13B,是因为 7B 做不到很多复杂的推理,当时我们希望是 13B 上线。结果发现今年 3B 已经超过了原来我们对 13B 的定义,3B 能够实现很多过去对于稍大尺寸的端侧模型的预测。我们就想说拿 3B 努努力就够了。今天我也讲过文本的摘要、生成,3B 已经跟云端大概是 97%-98% 的能力,已经很难察觉到有太大的差别,这已经够用了。

为什么要用 1B 呢?我们发现手机里有很多是要常设的,端侧大模型对手机的应用远比我们想象要广得多,手机里永远有一个大模型一直在运行。

我前阵子去了国内几个知名的人形机器人的实验室,我们也做机器人,在具身智能方面有一个大模型永远在运行的,我上午也说 3B 的模型在运行时要 750 毫安(功耗),这其实是受不了的,用上这个之后还是耗电的。这怎么办呢?我们是脉冲式的,你一会儿用一会儿没用,用的时候把它唤醒,大部分时候是没有用,综合下来一天可能就个把小时完全能够耗得起,比打游戏和拍照要完全省得多。

但是还有一个 24 小时都在线的,比如说地址围栏、你的行为、系统的参数是永远都在线的,这就要 1B。这 1B 不是在于复杂的推理能力,而是对本机的实时监测和记忆,这是交给 1B 模型在做的。所以在 1B 我们做得也是比较激进的,只是这个东西只是为手机服务,很少「丢」出来或者是对外沟通。

体验与哲学

Q:X300 上云端的 AI 功能已经有一些开始收费的倾向了,云端 AI 收费会如何把握边界?

周围: 我们有一个原则现在 vivo 有大量的端侧化,图像识别、声音识别,包括未来的同传、方言识别全部都端侧化,端侧化肯定是免费的。但是端侧化有一个问题,就是平台的算力要够,内存配置要够,至少是 8G 以上的配置。马上就面临另外一个问题,如果只有 4G 的低端机器,如果用户也要用的话,这时候可能用的是云端的功能,云端的功能在某种意义上是要消耗大量的成本的,这时候就考虑可能在成本上要分担一下。我觉得大概有一个趋势。

Q:现在手机厂商做 AI 容易陷入成做 AI 功能清单,用户普遍反映 AI 功能太多、太复杂。vivo 如何判断一个功能是否真正有价值?

黄梓勋: 我们内部对于 AI 体验这件事情有一个名词叫「无感化」。因为现在 AI 看似很强大,但是现在 AI 在使用渗透上还不算特别全面,一定程度上比较考虑用户对于如何使用这个功能的认知有很大的挑战。所以,我们一定要尽量弱化一定要通过一个按钮才能激活 AI 的功能或者是使用到 AI,而是通过无感化的设计,比如说保存文件的时候,我开启了一个录音,这个录音暂停或者是掐断就能自动获取 AI 的能力生成一个命名,在我们的理解里就定义成「无感化 AI」。

它确实是调用了刚才周围总一直介绍的端侧 3B 的模型,我们也做了很多优化,让底层的性能调度也好,包括在工作过程中对功耗的调度也做了很好的调优。我们在设计上弱化了用户一定要通过必要性的交互才能获得这些能力,而是在原有的使用功能和任务操作流中自然而来到这个节点,用 AI 能力来替换它的它传统需要手动调用这个功能或者是手动编辑的过程。

去年提出了重构系统体验,我们重构系统体验并没有刻意改变业务逻辑,或者是重新教会用户怎么使用 AI OS 或者是 AI 手机,而是在用户原有的任务流中,到了某一个节点我们认为 AI 预判到用户到这个场景,需要用到这样的功能时,可以很自然而然完成这个结果,这是我们做 OS 设计时一直想要追求的是「无感化」AI。

因为我们也做过一些测试过,当有一个按钮上面显示了 AI 的功能,对绝大多数用户来说会陷入一个短暂性的猜想,到底这个功能是什么,它会不会抓我数据,会不会带来一些无预期的结果。所以,我们在这个过程中避免的是创造新功能,或者是打造新场景,做 AI 和 OS 融合的过程中尽量回归到用户原有的习惯,用户原有的任务流不变,用最自然的方式,无感化帮客户完成。这是我们在 OS 体验过程中坚持的「无感化」的基本原则。

Q:如何平衡操作系统的稳定性和 AI 的快速迭代性?

周 围: 大家都知道我们 AI 团队这么多年下来自然也会遇到公司内部管理层,包括交付的时候是有很大的压力的,沈炜总有一个对 AI 团队的指示我觉得做得非常对,他说:AI 它不会创造新的需求,像我们做手机的,就应该把用户怎么用手机通过 AI 把它做得更好用。如果回到这个初心去看,我们工作可能是比较好开展的。

回到团队,因为我们软件有两三千号人,AI 又有一千多号人,几千号人包括做认知和做规划的人,很多时候就认为进入到 AI 时代,在这个划时代的到来是不是要颠覆性搞一个全新的东西出来,我身边有很多朋友给我们的感觉就是 AI 要到来肯定是划时代的,跟蒸汽机和马车一样是划时代的。

我觉得系统的稳定性和 AI 的颠覆性,我觉得最大的问题是真正要回到坐马车到远方是一个交通工具,至于你用蒸汽机还是马车才是产品形式。

现在我们非常平常心是用 AI 和手机的结合,哪些是变的?哪些是不变的?不变的是 AI 和 OS 融合有一句话叫作「系统功能的 AI 化」,大量的打电话做电话秘书,我们看相册也好,做便签也好,原来的这些功能都会做 AI 化,这些是传统功能的增强。哪些是变的呢?我觉得也是原来要实现的需求的变更。

比如说查一段字、一个应用,为什么要去猜我们的意图,这个意图只会出现在原子岛,高德地图或者是便笺,是不是要传给我存,或者是存给拼多多或者是淘宝搜东西。你会发现原来用户的需求其实没有变化,我们只是通过 AI 做意图判断,做你行为的预测。假如你真的丢掉某个应用中,我们可能帮你直接跑了。我们只是通过 AI 让用户更便捷、更易用、更好用了。不变的还是原来的手机,没有新增任何的功能,变的是把原来的功能重新思考,做得更好用了。

这样思考之后,我觉得这两年我们的行为、思考和认知及产品规划都自洽了,2023 年我自洽,感觉全新的时代到来,我们要做一个划时代的颠覆性的东西,那时候极不自洽,无论是对外沟通还是对内沟通都是极不自洽的,我们迷糊了一年多,但从这一年以来我们是非常自洽的,非常清晰知道自己在做什么。

Q:你们整体的 AI 时代的战略怎么走,刚才您说战略重心往端侧转移,那么原有的云端这块的训力怎么拆解?

周围: 因为我们是做智能终端的,不是做一个通用人工智能的企业,我们的战略其实还是在做我们这个企业该做的事,AI 上的战略是符合我们企业的,还是要做个人智能。去年有一个品牌有一个完整的描述叫「蓝心智能」,蓝心智能就是个人智能,个人智能可能还是很迷糊和笼统,你可以想象成希望为用户做一个「VIP 的个人助理」。

要做助理的话,生活中可能有一个帮你管日程的助理,但是可能做不到法务助理、报税助理和炒股助理,这些人是谁在做?这其实是行业里的金融公司在做、法务公司在做。比如说专门写专利的助理,这些是「专属助理」。我们的定位是一定为大家把手机变成各位的专属助理,这个专属助理可能手机公司会帮你管跟你个人强相关的东西,但是一些「专属」的就要搭台子了。今天上午我也说希望给专属服务和用户之间做一个桥梁,把专属助理也和用户拉到身边,我们做通用助理那一部分。这是我们完整的战略。

Q:vivo 也在做 AR、VR 眼镜,MR/AR 与手机的 Agent 会不会打通?

周围: 说到 Agent 其实在行业内以前就有很多服务,不是今天才有的,为什么大模型来了之后突然把它叫成智能体了呢?是因为它能够感知到我们身边的变化、能够洞察我们的意图、能帮我们做决策,才能把服务自动连接起来,就是因为这个变化才把它叫作智能体。

原来的服务天然还在,是因为我们加了这 4 个环节的建设所以变成了智能体。但是这个智能体在整个行业目前已经很通俗化、很广泛应用了。为什么手机公司还要回答这个问题呢?因为手机公司是真正懂用户个人习惯的,把用户的这些个人化特征在用户的授权下给到三方的服务商,他们的智能体一下就会变得很强了。

所以手机厂商在这一点上是产生了价值的,我们在为行业做平台的建设和支撑框架的建设,只是手机厂商多了一个身份,既给行业提供服务,可能手机上面还有一些电话、日程、短信这样的功能,所以同时我们做这两件事情。

Q:所以咱们还会跟 MR 设备做一些跨设备打通的考虑吗?

周围: 其实 MR 设备和手机最大的区别就是你得用摄像头看真实的物理世界,还要把物理世界识别出来之后再和数字世界关联,这个应用其实跟现在推的 AR 眼镜是很类似的。看到什么要识别出来,这时候是要请求服务还是做介绍都有一个应对关系,因为也是 OS 团队做这些事情,我们把它统一归总起来做的。

Q:今年 AI 硬件这块很火,手机厂商在 AI 硬件上有非常强大的优势,vivo 未来有没有往这个方面布局的规划?

周围: 我们公司其实成立了人工智能终端事业部,他们也有新品的发布计划,但是时间不应该由我来公布,我们的确像 vision 这样的产品,眼镜,包括公司也正式对外公布家庭机器人,这些是在做的。我们准备的东西肯定比对外官宣的东西要多。

今天大家也看到了我们的蓝河操作系统,其实我们蓝河操作系统已经适配了很多的芯片,包 ARM 的芯片,有 5-6 个芯片的适配。我们自己私下也接到了电力行业的中国企业,包括做 AI 眼镜的企业也找到我们沟通。

#欢迎关注爱范儿官方微信公众号:爱范儿(微信号:ifanr),更多精彩内容第一时间为您奉上。