整理|汤一涛

编辑| 靖宇

在智能手机行业,未来的 1500 天被视为一场即将发生的「聚变」。

随着大模型技术的爆发,以豆包 AI 手机为首的 GUI Agent 手机硬件应用落地,手机不再仅仅是通讯与娱乐的载体,正加速向「AI 个人计算设备」演进。

面对这一从功能机向智能机跨越以来最大的变局,手机厂商们正处于「八仙过海」的探索期:硬件形态如何收敛?交互界面如何革新?以及最重要的问题—— 如何避免成为 AI 时代的「诺基亚」 ?

在极客公园创新大会 2026 的活动现场,极客公园投资合伙人 Ashley 邀请到了 OPPO ColorOS 智慧产品研发总监姜昱辰。双方进行了一场深度对谈,从研发视角的转变、技术路线的抉择(GUI Agent vs 生态合作),到以「记忆」为切口的破局之道,全面剖析了 OPPO 对于 AI 手机终局的思考与实践。

关联阅读《 对话 OPPO AI 姜昱辰:手机才是 Memory 最好的土壤,AI 一定会彻底改变智能手机 》

嘉宾精彩 观点 :

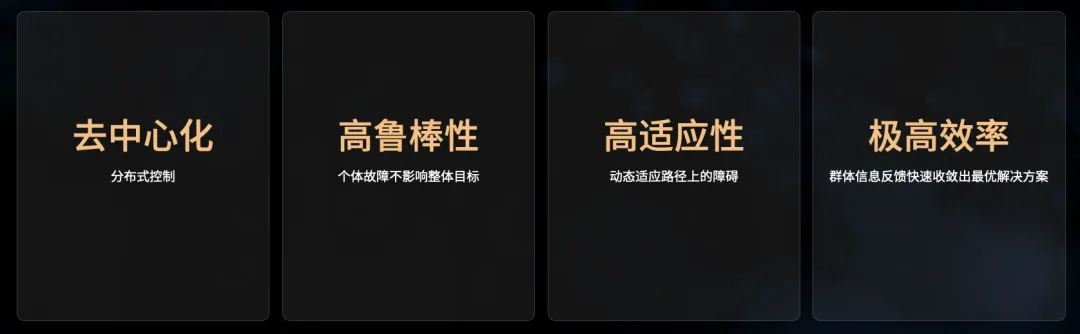

- GUI Agent 是长尾场景的兜底技术手段,OPPO 更倾向通过 Agent to Agent 实现生态互联。

- 「记忆」是 AI 手机演进的第一刀,因为只有「记得」才能「懂你」,进而提供主动式服务

- 构建记忆系统的核心挑战是隐私,唯一的解法是端侧计算,把数据留在手机里

- AI OS 的本质是「主动式」与「个人化」的交互革命,未来 AI 助手将与操作系统彻底融合为一体

以下为姜昱辰和 Ashley 在极客公园创新大会 2026 上的对话实录,由极客公园整理:

01

行业格局:手机厂商的 AI 探索

Ashley: 你曾经是一个创业者,现在在 OPPO 负责上亿用户量级的系统级产品,这两种研发体验有何不同?

姜昱辰: 还挺不一样的。

创业公司往往处于寻找 PMF 的阶段,做的是极度创新的事,不确定用户到底有没有这个需求。通常上线的是不完善的版本,到达一定用户量之后才会做 Scaling。

成熟厂商面对的用户,对你是系统级产品的期待,没有办法接受一个半成品。这导致我们在研发过程中必须极其谨慎。我们会在上线前进行深度的用户洞察、多轮用户共创及概念验证,确保产品在面世时已具备较高的完成度。

也有一些东西是不变的,比如怎么找 PMF。不管做什么产品、面对什么样的用户、有什么样的痛点,多多少少在回答同一个问题。

Ashley :可以用一个词概括一下 2025 年手机行业在 AI 领域的尝试吗?

姜昱辰 :用一个词的话就是「八仙过海」,不知道大家最近有没有关注自己手机上的变化,不管是 OPPO 还是友商们,大家做得挺激进的。比如 YOYO 做了很多智能体执行的工作,包括点咖啡;我们在记忆这条赛道上做了很多工作。

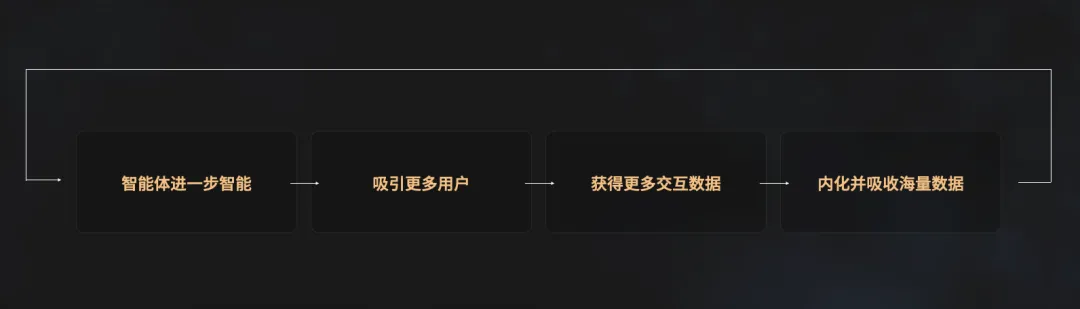

整个手机行业现在对于终局比较明确,形成了一些共识,比如要做无处不在、非常贴心的个人超级助理。但现在行业还是非常早期的阶段,所以怎么起步,从哪切入,各家有自己的回答。

姜昱辰和 Ashely 对谈手机 AI|图片来源:极客公园

Ashley :有点像智能手机特别早期的阶段。手机硬件形态没有收敛,系统的解法也没有收敛,甚至很多交互的解法也留有非常多的空白和想象空间。

提到 AI 手机,不得不提到豆包和努比亚合作的手机。这个手机搭载豆包手机助手,有非常高的系统权限的 GUI Agent。

作为手机厂商的视角是怎么来看这个事情(豆包手机)的?会不会给手机行业的方向和格局带来一些变化?

姜昱辰 :首先第一个怎么看的问题。我觉得「执行」还是一个非常确定性的方向,我们也在做非常多这方面的工作。

但是归根结底,GUI Agent 只是一个技术方案,最终要回到 为解决用户什么样的需求 。比如用户希望用 OPPO 手机点外卖、点咖啡,我们能不能帮用户做到,这个就是执行。是用 GUI Agent 的方式,还是 API 的方式,用户也没有那么关心。

我们作为手机厂商在这方面也没有倾向,更多还是看到在怎样的场景当中、什么样的技术方案最合适为用户解决问题。

第二是对方向和格局有没有影响,大概是没有。这个方向大家都在探索,(豆包手机)更多是把在小范围内探索的事情,更激进地推向公众舞台,让大家看到这个东西。这个是带来比较大的影响。

Ashley:当时你们内部有考虑过这条路线(GUI Agent)吗?

姜昱辰 :当然,我们一直在做相关的探索,但 我们内部更多认为 GUI Agent 是覆盖长尾场景的兜底方案。 因为我们的诉求非常多,非常不鲁棒(robust),需要这个东西去兜底。

但更大的服务用户的方式还是 Agent to Agent。我们不是一个公司、一个产品,服务用户;我们背后是美团、高德等一系列为用户提供服务的伙伴们。我们的态度是希望通过 Agent to Agent 的方式,通过生态的方式为用户提供最高质量的服务。

手机在这方面的尝试其实牵一发而动全身,因为它本身的生态位很特殊。应用的生态、OS 的生态,包括围绕着手机近距离场景的硬件设备生态,都会发生一些变化。

02

AI 手机的切入点:交互革命与「记忆」

Ashley :刚才您也提到大家对于下一代的随身计算设备的设想,可能是手机,也可能不是手机。它能够提供的理想体验,我相信大家有一些共同的想象,在科幻小说、科幻电影当中都有很多很向未来憧憬的画面。

从你一线的实践和观察的角度来看,这件事情(下一代随身计算设备)往前演进切入的第一刀是什么?

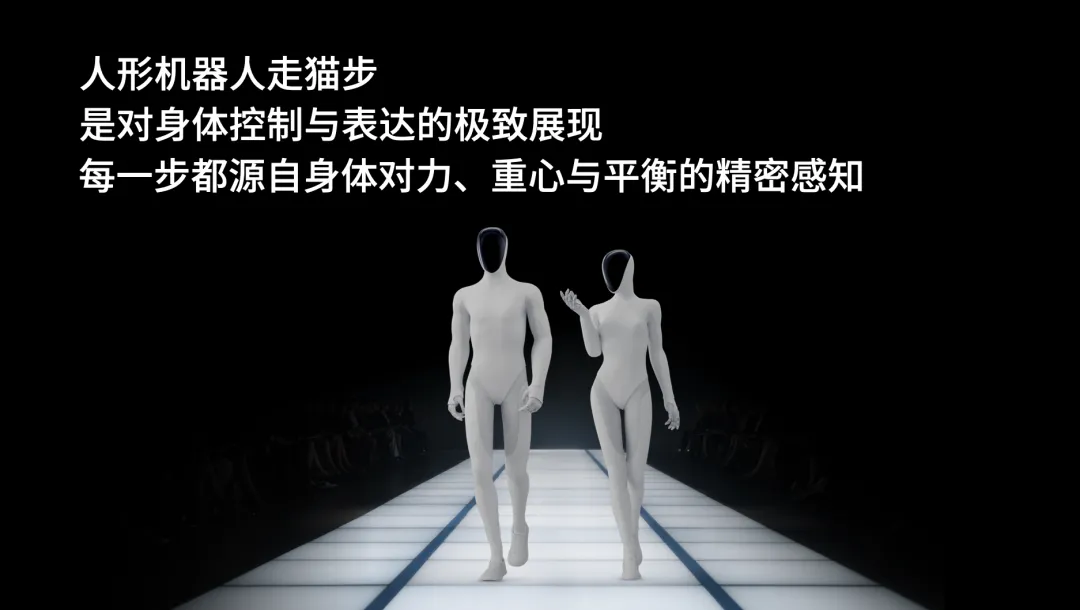

对比在智能手机时代,那个第一刀是 iPhone 出现的时候,把电容屏和屏幕交互的方案做到可以突破临界点的交互体验交付给大家,随即而来掀起整个智能手机时代。

姜昱辰 :这是很好的问题。在消费电子行业,每一次巨大的变革都是 交互的革命 ,人们获取资讯和服务的方式发生了改变。比如从功能机到智能机,原来通过打电话定外卖,现在 APP 点外卖;原来看报纸获取新闻,现在在今日头条里刷新闻。

从智能机到所谓的 AI 机,同样还是这个逻辑。问我最重要的是什么?还是交互革命。

我们未来早上起来,手机给我个人化的简报,告诉我人工智能昨天的重要大事是什么;出门的时候弹一个高德打车,问你是否要打;中午吃饭的时候告诉你,感觉你昨天很想吃大闸蟹,刚好旁边在打折,你要不要吃大闸蟹;到月末的时候,它弹出来告诉你,我知道你很想吃大闸蟹,但是我们没钱了,你要不考虑考虑楼下那个沙县小吃。你说 OK,就把外卖点上了。

未来可能是这样的资讯和服务的获取方式。

你问我第一步是,这有点像前面的问题,各个厂商的回答不一样,都在八仙过海。

OPPO 的话,我们认为是 记忆, 记得你才能更懂你。我前面描绘的场景都需要极度了解用户。不管做执行,还是给你资讯,都要足够了解你才能真的为你提供贴心服务。这个都是建立在理解你的数据、理解你的行为、理解你这个人的基础上。所以我们 OPPO 选择先做好记忆。

Ashley :记忆这件事,大家都在做,包括模型厂商和应用层,甚至中间出现很多创业公司就专攻记忆层,可见大家多多少少也有一些共识。但同样具体的落地和解题方法还是不一样,能感觉这个事情似乎挺难的。

这件事的痛点是什么?

姜昱辰 :我们的 slogan 是记得你才更懂你。对我们来说,做记忆这件事情首先是为了懂用户,大方向上是希望做到非常懂你的个人助理。这个事情需要我们对用户的数据有理解,对你的记忆有理解。

回到做产品本身,最终要为用户解决痛点。理解你的个人当中就有很多痛点可以帮你解决。

比如用户生活当中有非常多琐碎的信息记不住,我理解你的日程就可以回答你,明天在极客公园的活动是几点。

比如你今天看到了一篇公众号的文章很感兴趣,可以一键闪记。后面就可以问我上次看的那篇文章当中的某句话怎么讲来着?它就可以告诉你。

在琐碎信息的理解和提醒这件事情上,我们已经可以为用户提供很多服务,解决用户很多痛点了。

Ashley :我感觉小布记忆是把各种应用和 APP 收藏的动作整合起来了,这是用户的主动行为。

姜昱辰 :我们在 OPPO Find X8s 上线时的第一心智定位就是「跨 APP 收藏夹」。先做好这个第一心智的价值,后续才能帮你连点成线、整理回忆、做更多洞察。

Ashley :为什么当时从这个点切入?像相册里也有很多沉淀的数据,这些数据天然是用户生活流的记录,在这里也能挖掘出用户价值。

姜昱辰 :我们从用户痛点角度思考问题。

现在我们每天通过手机接收到的信息是爆炸式的,各种各样的信息混杂在工作软件、微信等各种不一样的地方。这个问题是相册本身解决不了的。

数据不等于记忆,我们的工作是把数据处理成记忆,让你不再为琐碎、爆炸且无头绪的生活感到困扰。只需要轻轻一问就能获取到想要的所有资讯,这是我们做的第一心智。把所有的东西通过一键闪记归集到小布记忆以后,它给用户提供的第一个价值就是让你的生活更井井有条,像你的第二大脑,帮你记住和管理你各种琐碎的事项,让你有时间处理更重要的事。

03

记忆的深度构建与隐私挑战

Ashley :小布记忆目前的交互方式是用户主动发起,我告诉我的手机,它才记录。它形成的记忆关于我的画像,似乎只是断点的画像。

这个距离我们理想当中的交互方式,似乎有很长距离,这个距离怎么跨越?

姜昱辰 :我们在 OPPO Find X9 这一代也做了自动收藏、自动记账功能,但我们在这上面相对比较谨慎。我们充分告知用户,并且对于收集的每一个来源都有开关——可以选择开还是关。 做记忆这件事情最重要还是保障用户隐私,要给用户充分的知情权 ,不然这个事情是很恐怖的。

而且我们是一家手机厂商,相对在做这件事情上会更加克制。这个是我们短期的回答。

长期来说,希望构建对用户 24 小时全方位的了解,当然是在用户充分授权的基础上。

Ashley: 小布记忆最理想的状态下,它能够形成的记忆框架,可能会是什么样的状态?

姜昱辰 :用更 toC 的用语来说就是第二大脑。

拆解下来:

第一层是 数据理解, 就是对不一样的数据源有充分的理解,理解能力,理解你的照片,理解你的视频,理解闪记的文章,理解你的行为轨迹……

第二层是 连点成线, 比如今天我的手机知道我在极客公园,也看到我昨天一键闪记今天的日程,也知道我跟 AI 聊过相关的话题,它能连接起来变成一个事件。

第三层是 连线成图。 比如我认识 Ashley 也挺久的,关于你的一切东西都可以被 link 到 Ashley 这个人节点上,就变成了一张图。我和 Ashley、极客公园等等一些事情之间的关联度,在线的基础上变成图。

总体来说,就是把数据变成记忆,把记忆连成线,把线连成图。

Ashley :你估计这个时间轴大概是多长时间?

姜昱辰 :其实也挺快,1-2 年内就会有非常不一样的体验。

姜昱辰和 Ashely 对谈手机 AI|图片来源:极客公园

Ashley :你是技术出身, 你觉得整个把记忆这件事情做好,是纯工程层面的问题,例如我堆人堆时间、找到足够的资源就能实现;还是里面存在技术上的断点和难点需要克服?

姜昱辰 :技术上来说有蛮多挑战,最现实的是隐私问题。不管豆包手机还是很多 AI 功能、AI 厂商,大部分数据都在云侧进出,你要构建用户的 3D 画像放在云侧,隐私问题是很多用户担心的。

这个解法非常单一,只能通过端侧化解决,把你的数据和计算留在端侧。

但这样又会引发功耗的问题。比如 32B 模型现在在屏幕理解方面可以做得比较好,但 32B 模型压缩到手机上要占 16GB 的内存,这个问题怎么解决?

但我是乐观派,我觉得 2-3 年会得到非常好的解决。

还有一个是记忆系统,如何做到自动更新,甚至是遗忘。

遗忘这个事情现在大家讨论比较少。可能以前你喜欢吃辣,现在不喜欢吃辣,这都是需要更新的信息。

记忆系统如何更新、如何遗忘,这也是非常大的挑战。我们有五个词形容这个事——安全隐私、即插即拔、 主动推理、自动更新 、端云结合。这是我们认为至少手机的记忆系统应该有的 5 个特性。

04

未来 AI OS 的定义与架构

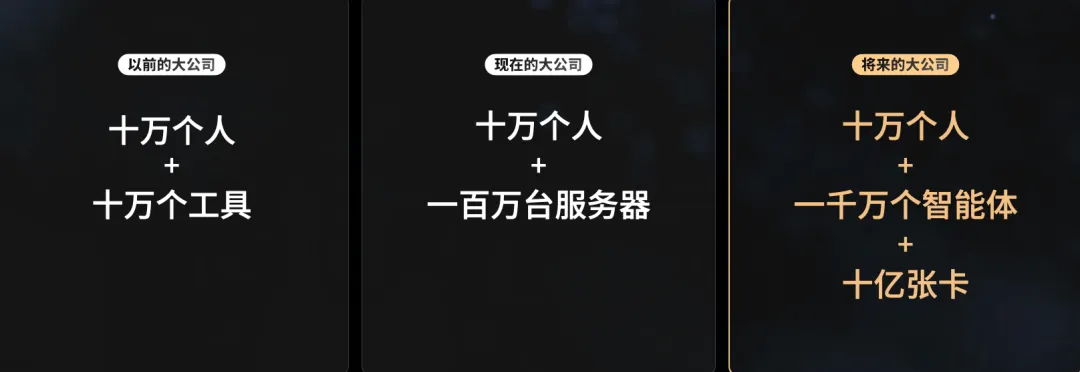

Ashley :手机毕竟还是运行在 OS 上的,包括所有为用户交付的服务也是依托于服务商的应用来存在的。 AI 手机时代的 OS 应该是什么样的?里面到底是哪些重要的素质?

姜昱辰 :这是一个很大的问题。

OS 的存在完全是基于硬件形态,在 PC 时代有 PC OS,在智能手机触屏机的时代有安卓,都是基于硬件的交互形式存在的。

如果问我 OS 的本质是什么,我觉得是交互。主动式和个人化,这是 AI OS 应该有的两个非常大的属性,

再多加一条就是高效。我今天跟它说一句话就能做到,我原来要打字打很久,点好久,现在我随便讲一句话就知道,这就是我心中 OS 的想法、形态。

其中什么是最重要的,如果让我一定选,当然是懂你,只有懂你的 AI OS 才能真正为你提供这些服务。

Ashley : 你们怎么样构建整个 AI OS 的,有哪些核心的层级?

姜昱辰 :我觉得首先是硬件层。它是物理相关的,在我们手机的形态还没有改变的时候,它底层终归是芯片调度,怎么做流畅,这些调度的事应该是最底层的。

在上面可能构建的是一些系统级的能力,我们称之为端侧计算。

还有记忆引擎,就是理解你手机上你的数据,构建关于你的记忆系统这一层。

第三个是智能体框架。前面也说我们挺重视执行这个事,我们更多更倾向是通过 A2A 的方式去做,就是在手机上怎么去与其他服务商的 Agent 进行交互。

在它之上有一个懂你的超级助理的应用层的服务,我们是这样的架构。

Ashley : 有没有可能在安卓之外长出一个新的开源 OS?

姜昱辰 :有可能,当年安卓长出来也是因为智能手机的普及,硬件形态导致了 OS 的出现。所以现在是一样的。

但也有不确定的地方,在于硬件形态大家都还没有完全的共识。OpenAI 更激进,它在考虑没有屏幕的硬件,那你说它是手机吗?

我们可能不那么激进,我们还是在原来的平台上去为用户服务。到最后硬件形态会收敛,有可能会有 iPhone 时刻,造成整个行业有一个共识的收敛。这个收敛以后,就会出现一个针对这个硬件形态的 OS,我相信这一定是会发生的。

Ashley : 觉得未来助手和 OS 会是什么样的关系?

姜昱辰 : 1、ColorOS(OPPO 的系统)注定会变成一个真正的 AIOS;

2、小布(OPPO 的 AI 助手)是 ColorOS 的拟人化表达。

05

如何避免成为「诺基亚」

Ashley :最后一个问题稍微有点挑战,从功能机到智能机迁移的过程中,诺基亚从之前的霸主地位一落千丈。 在 AI 时代如何避免成为智能手机时代的诺基亚? 你们内部对这个问题有过深入的探讨吗?

姜昱辰 :当然,我们内部的探讨非常多次。

我相信从智能机到 AI 机是一场大变革,这是大家共识的。但这个变革会发生什么,会怎么发生?事实上大家是没谱的,现在还是行业非常早期。

你回头看上一次变革,从功能机到智能机的时候,我们也挺晚的入场。我记得当年 OPPO 功能机还备货很多,那一年瞬间智能机开始主导市场,我们的功能机滞销了,这是比较大的挑战。

那次潮流当中,大家认为诺基亚掉队了,其实诺基亚做触屏机非常早,早于我们,甚至早于苹果。他不是没有做触屏机的尝试,也不是没有在做触屏技术新的 OS、新的形态推出。

那么问题出在哪儿?

我们内部也做过深入的探讨,我们有感觉,当时诺基亚整个团队更多在关心市场份额。他已经是行业老大了,多多少少就没有用户导向了,这个可能是他们所面临的一个真正的问题。

我们看到了用户的需求,这个导向下我们也会做出快速反应,这是最核心的。用户导向,倾听用户的声音,实际解决用户的问题,响应用户和市场的诉求,这个我们相对来说还是比较有信心的。